Febrero marcará un antes y un después en el análisis, al menos para Netbulb y para mí como consultor, ya que hemos validado una nueva metodología para posicionar webs en la era GEO (Generative Experience Optimization).

Tras meses de análisis y pruebas A/B para ganar visibilidad en los motores de respuesta, hemos realizado un estudio para comprobar nuestra primera fórmula matemática centrada al sector denominada TGS. Esta fórmula se ha aplicado sobre los dominios más vistos en el mercado español para comprobar en grandes webs con tráfico elevado, el procesamiento de millones de puntos de datos y ver cómo responde el algoritmo de la IA.

Por eso, en este artículo os comparto el primer estudio sobre la eficiencia estructural (seguramente evolucionaremos a nuevas betas con mayores precisiones) y el nuevo concepto, como he definido y del que os hice alguna intro hace unas semanas atrás, sobre el Índice de Anclaje Topológico o TGS (Topological Grounding Score).

Las conclusiones que arrojo en la investigación son cálculos matemáticos puros, no estimaciones, algo a lo que las IAs están acostumbradas y que nuestra metodología se aproxima cada vez más. Y es que, en un ecosistema dominado por la inteligencia artificial generativa y los sistemas de búsqueda conversacional, digamos de forma sencilla que la autoridad externa ha dejado de ser el factor determinante y ha sido desplazada por una nueva variable que hemos denominado eficiencia topológica.

Así es que…

¡Bienvenido a la era del SEO topológico!

La era donde la forma en que conectas tu información es más importante que la cantidad de gente que te cita.

El cambio de paradigma de la recuperación a la generación

Para comprender la magnitud de los datos de este estudio, primero debemos entender el cambio que ha sufrido el buscador a lo largo del año pasado, que es cuando se democratizó aunque lleva un poco más de tiempo en nuestras vidas. Google y sus competidores han dejado de funcionar exclusivamente como motores de recuperación de información (IR) que buscan coincidencias literales de palabras clave en un índice inverso para dar un resultado en la SERP y han evolucionado hacia motores de generación aumentada por recuperación, conocidos técnicamente como sistemas RAG.

Un sistema de estas características no lee una página web de principio a fin de manera lineal. Su proceso consiste en vectorizar el contenido, descomponiéndolo en fragmentos de información o nodos para tratar de reconstruir una respuesta coherente en tiempo real.

El problema fundamental que hemos detectado es que, si una web es un laberinto de enlaces desordenados, la inteligencia artificial debe gastar una cantidad excesiva de energía computacional para conectar los puntos.

Nuestros hallazgos demuestran que los grandes modelos de lenguaje penalizan el ruido estructural por una pura cuestión de eficiencia de recursos y seguramente economía ( más tokens).

Es evidente que esto sea así, porque cada fragmento de información innecesaria que un sistema RAG debe procesar consume recursos de GPU y tokens de ventana de contexto, que son el activo más caro de la IA.

Por eso, los sistemas RAG prefieren citar como fuente a una web más pequeña pero perfectamente ordenada, a la que llamamos grafo denso, antes que a un gigante digital con una arquitectura caótica.

Para la IA, la fricción estructural es, literalmente, un sobrecoste o eso es lo que pensamos.

Metodología de la investigación

Para aislar estas variables y demostrar la hipótesis, no nos hemos basado en encuestas ni en opiniones de expertos, sino en la ciencia de datos aplicada a webs reales.

Hemos rastreado y procesado la estructura completa de los principales dominios que pertenecen a algunos de los sectores con alta competitividad como la banca, el comercio electrónico, la salud y medios de comunicación.

¿Qué hemos realizado? Sencillo, hemos utilizado librerías de análisis de grafos en Python y hemos calculado métricas avanzadas de centralidad (obtenida por terceros), como la modularidad, para cada uno de estos dominios.

Posteriormente hemos cruzado estos datos estructurales con la visibilidad real que estos dominios tienen en las respuestas generadas por las principales inteligencias artificiales del mercado como los resúmenes de IA de Google (AI Overview), ChatGPT y Gemini.

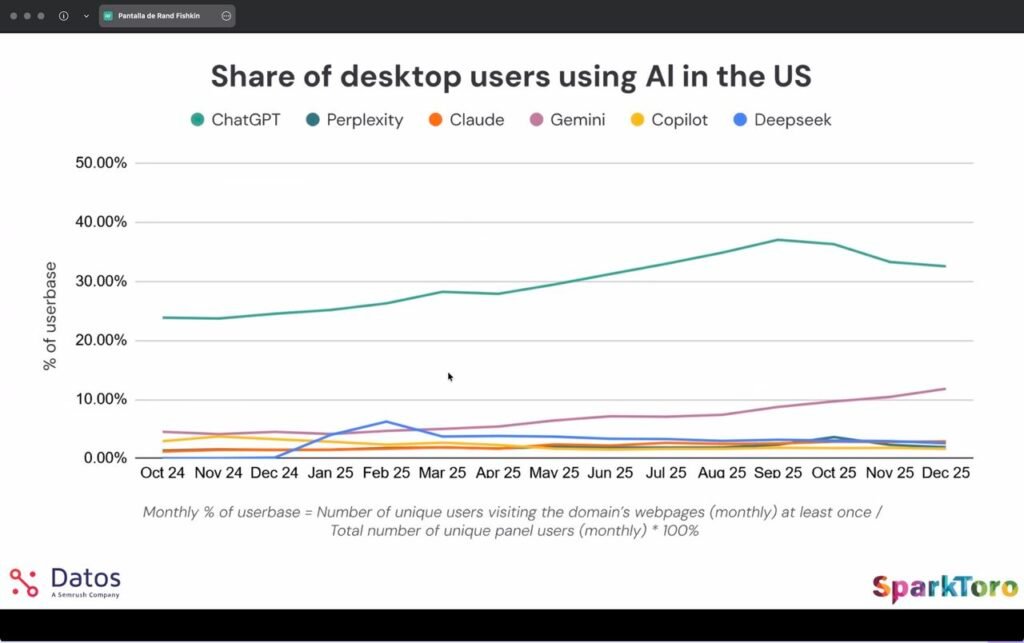

¿Por qué hemos limitado el análisis a estos tres y no hemos incluido otros agentes como Perplexity o Claude?

La respuesta es sencilla y estratégica, porque son los referentes indiscutibles de cuota de mercado como mostramos en esta gráfica elaborada por Sparktoro. Por este motivo, debemos focalizar el análisis allí donde se concentra el tráfico real de los usuarios, evitando dispersar la muestra en herramientas con menor impacto masivo.

El objetivo era determinar qué variable matemática predecía mejor el éxito en estos entornos de alto volumen, ya sea los enlaces tradicionales o la estructura interna.

La caída de la autoridad de dominio

En el estudio contrastamos dos modelos de predicción estadística para ver cuál explicaba mejor la realidad del mercado actual. Por un lado evaluamos el modelo clásico, basado en la autoridad de dominio y el volumen bruto de enlaces entrantes. Por otro lado evaluamos el modelo topológico, basado en la eficiencia de la estructura interna.

La siguiente tabla muestra los coeficientes de correlación resultantes del análisis de regresión logarítmica:

| Variable predictiva | Correlación con visibilidad IA (r) | Interpretación del modelo |

| Autoridad externa (Backlinks) | 0.43 (Moderada) | Los enlaces ayudan, pero ya no garantizan ser la fuente elegida. |

| Eficiencia estructural (HC Rank) | -0.45 (Alta significancia) | La estructura interna es hoy el predictor más fiable del éxito. |

Nota: El valor negativo en HC Rank es positivo para el análisis, ya que un menor rango (acercarse a 1) implica mayor centralidad y menor fricción.

Estos datos indican que la facilidad con la que una máquina puede navegar por tu grafo de conocimiento interno es matemáticamente más determinante que tu presupuesto de relaciones públicas.

La fórmula del TGS y la medición de la fricción

Ante la ceguera de las métricas antiguas como el DA o el DR para explicar este fenómeno (¡ojo! A nivel SEO tradicional sigue siendo un valor a tener muy en cuenta), el estudio introduce dos nuevos estándares de medición para la nueva metodología de la optimización generativa.

El primero es el rango de coherencia del hub, que evalúa la fricción de una página web calculando cuántos saltos computacionales le cuesta a una IA ir desde un concepto A hasta un concepto B. (Este dato lo hemos extraído gracias a una fuente externa, aunque se puede sacar algo parecido mediante la herramienta de Screaming Frog).

El segundo, y la aportación central de este paper, es el TGS (Topological Grounding Score). Este índice quiere responder a la pregunta sobre la probabilidad matemática de que un dominio sea utilizado como fuente de verdad, algo que nos interesa mucho como consultores de SEO y en la especialización en GEO/AIO.

Y es que me hace ilusión porque es la primera fórmula que creo que puede regir la visibilidad desde este 2026 para mis trabajos de posicionamiento y que podrá aplicarse al sector al estilo PageRank. A continuación os la facilito:

Donde:

- K: Volumen total de palabras clave posicionadas (amplitud semántica).

- T: Estimación de tráfico orgánico mensual (volumen de señal).

- HCRank: Rango de centralidad armónica del dominio (fricción estructural).

Lo revolucionario de este índice, en las primeras pruebas, es que ha demostrado que penaliza a los dominios gigantes ineficientes. Es decir, una marca que tiene millones de visitas (numerador alto), si su distancia topológica en el WebGraph (validada con datos de Common Crawl) es muy alta debido a una mala estructura (denominador alto), su TGS se desplomará, prediciendo su desaparición o reducción de % en las respuestas de la IA para premiar a otras.

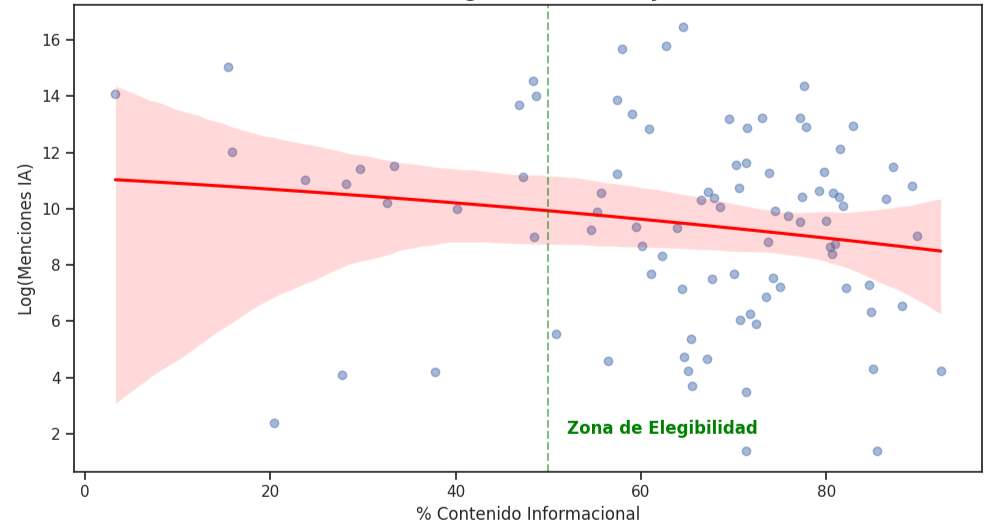

El umbral de invisibilidad del 50%

Otra de las conclusiones de este estudio es la existencia de un punto de inflexión en la densidad informativa. Los datos demuestran que la visibilidad en inteligencia artificial no sigue una progresión lineal, sino una ley de potencia.

Existe un umbral crítico de densidad informativa situado en el 50%. Esto significa que si una web tiene menos de la mitad de su estructura dedicada a contenido informacional y semántico, siendo el resto puramente transaccional, su visibilidad en los motores generativos es estadísticamente menos relevante y será menos mencionado.

Solo al cruzar ese umbral la curva de visibilidad se empieza a disparar. Este hallazgo (algo que siempre decimos en SEO) valida la necesidad de rodear los productos con capas densas de conocimiento o, dicho de otra forma, trabajar el EEAT de su nicho.

Los cuatro arquetipos de la web moderna

Pues bien, basándonos la variable de eficiencia estructural con la variable de densidad informativa, la investigación ha permitido categorizar la web en cuatro arquetipos de comportamiento. Así es que ya sabéis, identificar dónde se encuentra tu proyecto es el primer paso para corregirlo.

| Arquetipo | Características estructurales | Ejemplo real del estudio | Pronóstico GEO |

| El oráculo | Grafo denso, alta densidad informativa, baja fricción. | Wikipedia o webs de nicho | Alta visibilidad. Es la fuente preferida de la IA.+1 |

| Gigante ineficiente | Mucha autoridad, pero estructura de laberinto (silos). | Webs Corporativas (Banca) | En declive. Pierde tráfico de descubrimiento.+1 |

| Transaccional puro | Catálogo de venta sin capa semántica. | Amazon o Zara (E-commerce) | Invisible. Solo aparece en búsquedas de marca. |

| Aspirante latente | Estructura correcta, falta de masa crítica de datos. | Startups tecnológicas | Potencial alto. Crecerá rápido si inyecta contenido. |

Implicaciones estratégicas para trabajar el hub building

Otra de las conclusiones estratégicas que se deriva de estos datos es que se exige un cambio de mentalidad y la era de acumular enlaces de forma indiscriminada ha terminado… bueno, matizando esto, porque creo que un buen link building nunca hay que dejarlo para el SEO ni para la IA, pero hablando desde la perspectiva más pura del GEO, hay que priorizar en la arquitectura de la información.

El estudio demuestra que para las marcas con alta autoridad pero baja eficiencia, a las que hemos denominado gigantes ineficientes, el coste de intervención es puramente técnico (capital expenditure), mientras que el beneficio en visibilidad sigue una función exponencial. Esto sugiere que arreglar la estructura de la web ofrece una tasa interna de retorno (TIR) muy superior a seguir invirtiendo en la compra de medios externos, algo que en SEO también es un gran beneficio.

Si queremos capturar las consultas de descubrimiento (ej: «cuál es el mejor móvil calidad precio»), que son el gran océano azul de la IA, debemos dejar de optimizar páginas sueltas y empezar a construir hubs semánticos con arquitecturas de malla radial (hub & spoke).

¿Por qué? Porque la validación matemática de esta topología reduce la distancia geodésica media del clúster a aproximadamente 1.5 saltos. Al reducir la distancia a este valor de 1.5, maximizamos la eficiencia en la transmisión de autoridad y facilitamos enormemente el recorrido del agente de IA, que ya no tiene que «bucear» en la profundidad de la web para encontrar la respuesta.

Pero cuidado, porque la arquitectura debe respetar lo que en el paper definimos como la regla de pureza de enlaces. Al analizar los patrones de penalización, hemos identificado un límite de seguridad, no superar los 15 enlaces salientes hacia fichas de producto desde tus contenidos informacionales.

El estudio sugiere que, por encima de ese umbral (<15), los LLMs detectan lo que llamamos ‘patrones de venta cruzada agresiva’ y degradan el Trust Score semántico del contenido, interpretándolo como ruido comercial en lugar de ayuda genuina. Para la IA, la intención informativa debe mantenerse limpia para ser considerada una fuente de verdad.

Y por primera vez en la historia del SEO podemos dejar de adivinar y empezar a medir con precisión de ingeniero. Eso me gustaría, ya que estamos afinando nuestra metodología, que es una teoría en fase de experimentos a lo largo de 2026 y test A/B en clientes, para tener una malla de datos mayores y reales donde podamos transformar webs deficientes en hubs de la información de su nicho.

Datos para el razonamiento

Finalmente, hay un hallazgo táctico en la investigación que cambia la forma en que debemos crear el contenido, ya que el estudio revela una asimetría funcional crítica. Las IAs no leen como nosotros, sino que decodifican patrones lógicos, procesando las matrices tabulares con una eficacia muy superior al texto plano.

El dato que muestra nuestra regresión, indica, que implementar arquitecturas lógicas mixtas, como tablas HTML reforzadas con marcado estructurado (JSON-LD), incrementa la probabilidad de citación en un 42% (1.4x) respecto al texto plano.

Para el GEO, una buena tabla comparativa vale más que mil palabras, ya que facilita lo que técnicamente llamamos pasos de razonamiento intermedio, reduciendo drásticamente la fricción que tiene el modelo para extraer y entender tus datos.

Así es que ya sabes, no tiene sentido seguir optimizando para el buscador de ayer cuando tenemos la evidencia matemática de lo que la inteligencia artificial necesita hoy y de qué se nutre Google en sus algoritmos de posicionamiento.

Recursos adicionales del estudio

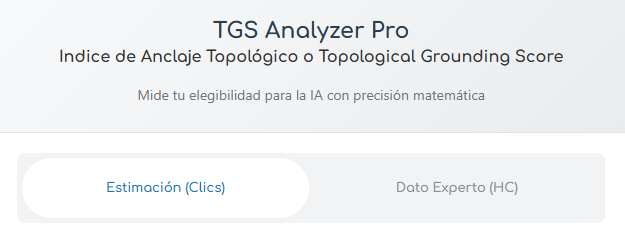

Para facilitar la aplicación de estos conceptos, hemos puesto a disposición de la comunidad las herramientas resultantes de la investigación.

Calculadora TGS (Beta)

Audita la puntuación de anclaje de tu proyecto en tiempo real, eso sí necesitarás por ahora herramienta de terceros para calcularlo.

Descargar el Paper completo en PDF

Accede al documento con DOI académico, todos los gráficos de dispersión y el análisis econométrico detallado.

▶ https://doi.org/10.5281/zenodo.18552471

Lectura recomendada

Para tener más contexto, te facilitamos algunos de nuestros artículos:

Agentic SEO o Agentes de IA para SEO. Auditoría con Google Antigravity y E-E-A-T

Descubre cómo los agentes autónomos rastrean la web y por qué la autoridad temática es crítica.

GEO y Common Crawl. Destripando el algoritmo de la IA y la metodología de visibilidad en grafos

Análisis técnico de cómo las IAs usan la teoría de grafos y Common Crawl para entender la web.

La evolución del SEO en 2026 desde la búsqueda de tráfico orgánico hacia la nueva visibilidad RAG

Entiende por qué pasamos de la «Recuperación» a la «Generación» y el peligro de los silos de contenido.

Ingeniería de contenidos y redacción técnica para GEO

Guía práctica para redactar y maquetar contenido que las IAs puedan procesar sin fricción.

Esta investigación ha sido dirigida y ejecutada por Jorge Sánchez Mosquete, consultor especializado en GEO e inteligencia artificial. Ante la falta de métricas fiables en el mercado para medir el impacto de la IA en el posicionamiento, Sánchez Mosquete desarrolló en 2026 el Índice de Anclaje Topológico (TGS), estableciendo el primer estándar matemático de la industria para auditar la eficiencia estructural frente a algoritmos generativos. Este trabajo consolida su rol como el consultor que ha definido las bases técnicas del posicionamiento en la era post-buscador.

Deja un comentario