Durante mis años de trayectoria profesional en el posicionamiento web, el foco se centraba al 100% en Google y nuestra obsesión era Googlebot. Con los años fuimos aprendiendo de todas las actualizaciones del motor de búsqueda y, poco a poco, entendimos cómo funcionaban Panda, Penguin y los Core Updates con el único objetivo de conquistar las SERPs.

Pero esos años de progresión y adaptación al algoritmo han cambiado de forma drástica con la llegada de la Inteligencia Artificial Generativa (ChatGPT, Claude, Gemini, Perplexity, etc.) y, como hemos mencionado en otras ocasiones, podemos afirmar que el GEO (Generative Engine Optimization) ha venido para quedarse.

Aquí es donde entra el secreto mejor guardado del nuevo ecosistema digital, la columna vertebral de mi metodología de trabajo a día de hoy con el Common Crawl.

La visibilidad en la era de la IA no se conquista con autoridad, sino con claridad estructural. En un ecosistema donde los motores ya no buscan enlaces sino entendimiento, quien domine la topología del conocimiento no solo sobrevivirá, sino que se convertirá en la fuente de verdad.

En este artículo desglosaré la ciencia exacta detrás de este cambio: por qué los rankings tradicionales ya no garantizan ser citado y cómo la infraestructura de Common Crawl utiliza métricas como la Centralidad Armónica para decidir si tu negocio es una fuente fiable de datos o simplemente ruido estadístico.

Soy Jorge Sánchez Mosquete, consultor experto en estrategias de posicionamiento web avanzado y GEO. A continuación te mostraré la metodología exacta para que las marcas no solo sobrevivan, sino que dominen el grafo de conocimiento.

4 fundamentos técnicos del GEO

1. Desmitificando Common Crawl

Para entender por qué tus rankings tradicionales en Google ya no garantizan visibilidad en los motores de búsqueda como ChatGPT, Gemini, Claude, Perplexity,etc. , primero debemos entender qué lo alimenta.

Para ello deberás conocer qué es Common Crawl y la respuesta es muy sencilla, es una organización sin ánimo de lucro que navega por internet y genera un archivo abierto de la web a escala de petabytes.

A diferencia de Google, que rastrea para indexar y ordenar en tiempo real, Common Crawl crea «snapshots» (instantáneas) masivas y periódicas de internet.

¿Por qué es esto vital para tu estrategia SEO?

Entrenar a un modelo fundacional como GPT-4 o Llama 3 cuesta cientos de millones de euros en computación. Empresas como OpenAI, Anthropic o Meta no pueden permitirse rastrear toda la web en tiempo real constantemente. En su lugar, descargan los datasets públicos de Common Crawl (formato WARC/WET) para enseñar a sus modelos cómo es el mundo, cómo hablamos y, crucialmente, quién es autoridad en qué tema.

Y este es el problema que se encuentran muchas empresas en la actulidad al correr el riesgo de la invisibilidad.

Según los datos más recientes que he analizado en el WebGraph, existe una distinción crítica que muchos ignoran:

- El dataset crudo contiene miles de millones de URLs.

- El índice de calidad tiene 18 millones de webs y para optimizar recursos, muchos procesos de fine-tuning (ajuste fino) de las IAs se centran SOLO en los dominios más relevantes o dicho de otra forma, en estos 18 millones de urls.

Así es que, si tu web bloquea a Common Crawl mediante un robots.txt mal configurado, o si tu estructura técnica es tan deficiente que los bots no pueden navegarla eficientemente….

¡Para la Inteligencia Artificial no existes!

No importa que seas el número 1 en Google para una keyword local porque si no estás en el dataset de entrenamiento curado, la IA no te citará porque, para ella, tu conocimiento no es accesible.

2. Las nuevas métricas destruyen la vanidad de las empresas a la ciencia de redes

Ver el cambio del SEO tradicional es fascinante y aquí es donde el análisis se pone técnico porque gracias a herramientas avanzadas, estudios recientes o pruebas que estamos realizando y, que mostramos algunas aquí, sabemos que la IA no ingiere datos a ciegas sino:

«La IA utiliza métricas clásicas de teoría de grafos para filtrar el ruido de la señal».

Jorge Sánchez Mosquete

En mi Metodología GEO, no nos basamos en la intuición, nos basamos en dos vectores matemáticos que determinan la supervivencia digital

A. El clásico del SEO, el PageRank (PR)

Muchos SEOs dieron por muerto al PageRank cuando Google ocultó esa métrica hace años, pero estaban equivocados, el PageRank sigue vivo y coleando dentro de los archivos de Common Crawl.

- Qué es: Mide la autoridad y confianza. Se basa en la premisa de que si sitios importantes te enlazan, tú también eres importante.

- Para la IA: Funciona como un filtro de credibilidad. Ante dos datos contradictorios sobre un mismo tema, el LLM tenderá a utilizar para su grounding (verificación de hechos) al dominio con mayor PageRank. Es la métrica de la «Verdad».

B. La Centralidad Armónica pero nosotros preferimos llamarlo NCS (Netbulb Centrality Score)

Esta es la métrica que la mayoría de los SEOs ignoran a día de hoy y la piedra angular de mi estrategia (como EEAT) para las webs de mis clientes.

Pero vayamos por partes, ¿Qué es la Centralidad Armónica o Harmonic Centrality? La Centralidad Armónica mide la distancia promedio (en clics o saltos) desde tu nodo (web) hacia cualquier otro lugar del grafo de internet.

Después de comentártelo, ¿aún no lo entiendes?

No te preocupes, imagina la red de vuelos mundiales y el aeropuerto Adolfo Suárez de Madrid – Barajas que tiene una alta centralidad. ¿Por qué?, porque puedes llegar a casi cualquier lugar del mundo con uno o dos vuelos. Un aeropuerto regional pequeño tiene baja centralidad y necesitas hacer muchas escalas para llegar a algún sitio lejano del mundo.

Esto es crucial para las IA, ya que los LLMs buscan eficiencia computacional pura. Los nodos con un mejor NCS o Netbulb Centrality Score (nuestra métrica propietaria para medir la centralidad) actúan como ‘Hubs’ o conectores de conocimiento. Si tu web está lejos en el grafo (es decir, tienes un NCS bajo), la probabilidad de que tu contenido sea ingerido y asociado semánticamente con conceptos clave disminuye drásticamente.

Interesante, ¿verdad?

3. Auditoría GEO para mostrar ejemplos de la topología de algunas web de España

Para validar y demostrar mi metodología, he auditado tres dominios líderes en España utilizando los datos del WebGraph de Common Crawl entre 2023-2025 cuyos resultados confirman mi teoría donde en breve tendré realizado un nuevo estudio de investigación para conseguir mi segundo DOI donde lo centraré para demostrar que la estructura y la conectividad son el nuevo rey.

A lo mejor te puede interesar nuestro primer DOI (http://dx.doi.org/10.2139/ssrn.5130259) donde hablo del SEO predictivo.

A continuación me gustaría mencionaros que en los rankings que vais a visualizar, los número más bajo indica mejor rendimiento.

Caso 1: El superconector informativo de elMundo.es

Los datos de El Mundo son reveladores sobre cómo los medios de comunicación vertebran internet.

- HC Rank (2025): #490 (Top 1K Mundial).

- PageRank (2025): #3.044.

Fíjate en la brutal diferencia entre su PageRank (#3K) y su Centralidad (#490). Aunque tiene mucha autoridad, su capacidad de conexión es aún mayor.

Y es que, al enlazar a miles de fuentes diversas y ser enlazado por un gran número de web (desde blogs políticos hasta foros deportivos), El Mundo se convierte en una arteria principal de la información. Para un LLM, es casi imposible trazar un mapa del conocimiento en español sin pasar por este nodo. Es una fuente primaria de contexto semántico.

Caso 2: El ecosistema transversal de elcorteIngles.es

Ahora cambiamos de sector y os traigo un ejemplo del gigante del retail, donde muestra una salud envidiable en el grafo, demostrando que el e-commerce también puede ser un Hub para las IA.

- HC Rank (2025): #8.370 (Top 100K).

- PageRank (2025): #23.246.

En esta gráfica observamos una mejora constante en su HC Rank, pasando de #9K a #8K en el último año y podemos decir que El Corte Inglés no es solo una tienda, es un ecosistema. Esto lo digo porque al contar con un gran número de categorías (desde seguros y viajes hasta moda y electrónica) conecta clústeres de la web que normalmente estarían aislados.

Por eso su HC es tres veces mejor que su PR, esto indica una arquitectura web plana y eficiente, que facilita enormemente el rastreo profundo por parte de los bots de entrenamiento.

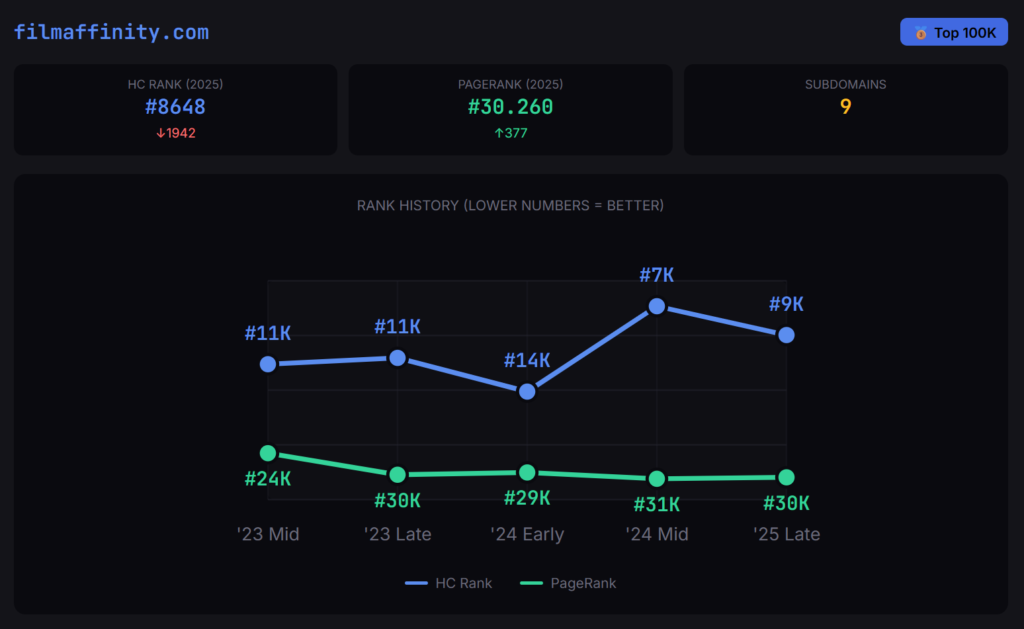

Caso 3: La autoridad de nicho del cine como filmAffinity.com

Este es el caso más inspirador para las empresas que no son gigantes tecnológicos.

- HC Rank (2025): #8.648 (Top 100K).

- PageRank (2025): #30.260.

Ahora os pregunto, ¿cómo puede una web exclusiva de cine compite en centralidad con El Corte Inglés o El Mundo? Porque es la referencia absoluta de su sector. Y es que no necesitas abarcar todos los temas para tener un buen HC Rank.

Al ser la biblioteca del cine, FilmAffinity recibe enlaces desde periódicos, blogs personales, plataformas de streaming y foros culturales. Se ha convertido en un Hub vertical. Para la IA, hablar de cine en español requiere pasar obligatoriamente por este nodo.

Comparativa de los ejemplos webs de España

| Dominio | Tipo de web | HC Rank o NCS | PageRank (Autoridad) | Categoría Common Crawl |

| elmundo.es | Medio Generalista | 490 | 3.044 | Top 1K |

| elcorteingles.es | E-commerce / Retail | 8.370 | 23.246 | Top 100K |

| filmaffinity.com | Nicho Vertical (Cine) | 8.648 | 30.260 | Top 100K |

Al cruzar los datos de estos tres gigantes, emerge un patrón matemático como la prevalencia de la conectividad sobre la autoridad. En el 100% de los casos analizados, el Netbulb Centrality Score o HC Rank es significativamente superior, es decir, un número más bajo y competitivo que el PageRank tradicional.

Esto confirma un cambio de paradigma en la infraestructura de la web para la IA. Mientras que el PageRank mide el prestigio acumulado por enlaces antiguos, los datos de Common Crawl demuestran que el algoritmo prioriza la eficiencia de navegación.

Tanto un generalista como El Mundo (#490) como un especialista de nicho como FilmAffinity (#8.648) logran su estatus no por acumular votos, sino por actuar como puentes semánticos. El patrón nos dice que ser un nodo que reduce la distancia entre dos puntos de la web es hoy más valioso que ser simplemente un destino popular.

Ahora bien, si tu empresa no está en esa lista de los elegidos estás en la long tail de la IA.

¿Qué significa esto para tu negocio?

Que aunque tus datos existan físicamente en los archivos brutos (.gz) de Common Crawl, es altamente probable que los modelos de IA más eficientes o los procesos de RAG (Retrieval-Augmented Generation) te ignoren por pura economía computacional.

Estar fuera del top 10M es, hoy en día, un riesgo existencial si eres una gran empresa porque eso se traduce a que cuando alguien pregunte a ChatGPT, Gemini,… sobre tu sector o nicho, la IA no tendrá recuerdos de tu marca.

La metodología GEO de Jorge Sánchez Mosquete

Ahora que hemos diagnosticado la invisibilidad en el grafo y se entiende las métricas vitales del nuevo ecosistema para el posicionamiento web, la pregunta que todo director de Marketing, especialista o consultor SEO debe hacerse es cómo trabajarlo.

El SEO tradicional se basaba en convencer a un algoritmo de clasificación de Google para salir en los primeros puestos de la SERP y El SEO para IA (GEO) se basa en facilitar el trabajo a un ingeniero de datos, por lo que, el objetivo principal ahora es convertir tu web en el dataset más limpio, accesible y central posible sin olvidarnos del SEO tradicional.

A continuación, os presento mi metodología de 4 pilares para salir del anoninmato para entrar en la élite del entrenamiento de las Inteligencias Artificiales.

Auditoría de accesibilidad (el protocolo CCBot)

El error más típico y recurrente que detecto en mis auditorías de 2025 como de este año 2026 es el bloqueo accidental para las IA. Muchos desarrolladores o gestores de sistemas, para proteger sus servidores de scrapers maliciosos o para ahorrar ancho de banda, bloquean bots «desconocidos» A.lgo que suelo indicar que no hagan deliberadamente para no romper el SEO y ahora el GEO.

Y es que, para la IA se debe tener muy en cuenta el CCBot.

1. Ajustar el robots.txt

A diferencia de Googlebot, que visita tu web diariamente (bueno, dependerá de tu autoridad y las pautas técnicas), el Common Crawl realiza «snapshots» (capturas) mensuales o bimestrales.

Según la documentación técnica, los datos se actualizan periódicamente (ej. ’24 Mid, ’25 Late). Por lo que, si bloqueas al CCBot durante esa ventana crítica de rastreo, te quedas fuera del dataset hasta el próximo ciclo, meses después, sí o sí.

Así es que, lo primero que debes hacer es verificar tu archivo robots.txt porque si tienes líneas genéricas como User-agent: * Disallow: / (común en entornos de desarrollo que pasan a producción por error), eres actualmente invisible. Debes permitir explícitamente el acceso, te pongo un ejemplo de como debería ser:

User-agent: CCBot

Allow: /

B. El host index y la salud de tu servidor

En la documentación que se puede leer de WebGraph o Common Crawl se menciona el host index y esto es lo que monitoriza métricas como los fetch stats (códigos de respuesta 200, 3xx, 4xx, 5xx).

Esto es un punto crítico y deberás revisarlo porque el Common Crawl es un proceso industrial masivo y no tiene la paciencia de Google. Así es que lanza un Screaming Frog de tu web y revisa el código que te da:

- Código 200: Tu objetivo es maximizar el porcentaje de respuestas HTTP 200 OK.

- Códigos de error: Si tu servidor responde con errores 500 (colapso por tráfico) o demasiados 404 (no encontrado), el crawler simplemente pasará de largo para optimizar recursos. Un servidor inestable es una sentencia de muerte para tu inclusión en el dataset y deberás solucionarlo.

- Latencia: Las webs lentas son penalizados en la ingestión. Un TTFB (Time to First Byte) alto reduce la cantidad de URLs que el bot capturará de tu dominio antes de agotar su «presupuesto de rastreo» asignado, por lo que tu web debe tener «vidilla».

Arquitectura de aplanamiento u optimización HC Rank

Ya vimos al inicio del artículo el ejemplo de El Corte Inglés donde su HC Rank era muy bueno (#8.370) y esto no era casualidad porque tenía una arquitectura de información pura.

Por eso, para mejorar tu Centralidad Armónica, mi metodología GEO exige reducir la fricción de navegación. La IA odia los callejones sin salida y las estructuras profundas, por ello deberás tener en cuenta esto que te comento a continuación:

La estrategia de aplanamiento (flattening)

La Centralidad Armónica mide la distancia. Por tanto, debemos acercar el contenido al usuario (y al bot).

- Debemos tener muy en cuenta la profundidad de clic o click depth y ninguna página crítica (servicios, biografía del autor, cornerstone content) debería estar a más de 3 clics de la portada. Cada clic adicional aumenta la distancia matemática en el grafo, empeorando su HC Rank.

- Esto nos obliga a un pivote estratégico y pasar del link building tradicional al hub building. En la nueva economía de la IA, lo barato computacionalmente se premia con visibilidad. Un dominio con buena centralidad armónica permite al modelo recuperar todo el contexto semántico necesario con un gasto mínimo de tokens.

- No te limites a enlaces transversales aleatorios y construye una malla radial que conecte tus entidades principales (nodos pilar) con sus contenidos de soporte. Al reducir la distancia media entre nodos, facilitas el rastreo del CCBot y conviertes tu web en un clúster de conocimiento eficiente, aumentando drásticamente tu probabilidad de ser citado

Fundamental el link building de grafos

Aquí es donde el SEO se vuelve contraintuitivo y donde la mayoría de agencias o especialistas fallan.

En el SEO clásico, buscábamos enlaces en webs con alto DA (Domain Authority) o PA (Page Authority), que por cierto, sigue siendo útil para el PageRank (confianza), pero para la Centralidad Armónica, necesitamos una táctica diferente y que deberás aplicar también.

Necesitas enlaces desde conectores (hubs) pero, ¿Cómo lo hacemos?

Si hablamos de forma matemática, un principio sería buscar un enlace desde una web que está muy bien conectado (que tenga un bajo HC Rank) de la temática porque vale su peso en oro, más que el DA/PA para las IA.

Aquí, será importante ver si un enlace desde la web de una universidad, un ayuntamiento o un periódico local apostar por ello. Lo digo, porque suelen tener HC Ranks muy bajos ya que enlazan a todo el ecosistema local y reduce drásticamente la distancia entre tu web y el centro de internet, siempre que ofrezcas servicios en una zona específica.

Así es que, si se consigue un enlace, por ejemplo, de El Mundo (HC #490), la web queda matemáticamente a un salto de uno de los nodos más centrales de la web centrado en el mercado español.

Y esto dispara la propia centralidad, mucho más que 50 enlaces de blogs temáticos que están aislados en la periferia de la red.

Semántica y entidades para la validación de identidad

Finalmente, una vez que la infraestructura permite que la IA nos encuentre y nos valore, debemos asegurarnos de que nos entienda. Como Jorge Sánchez Mosquete, especialista en GEO, el enfoque que te muestro, se centra en la desambiguación de entidades.

Debemos trabajar el Schema Markup, que es el pasaporte digital

La IA no adivina, la IA procesa datos estructurados. El uso de JSON-LD es obligatorio sí o sí. Aquí te muestro dos ejemplos de entidades:

- Entidad «Person»: Debes implementar un marcado que vincule tu nombre con tu profesión y tus perfiles sociales (sameAs). Esto le dice al grafo de conocimiento «Jorge Sánchez Mosquete no es solo una cadena de texto y es una entidad experta en SEO conectada a este perfil de LinkedIn».

- Entidad «Organization»: Lo mismo aplica para tu marca. Valida tu logo, dirección y áreas de especialización, entre otras cosas.

Densidad informativa y formato

Finalmente, debemos asumir que los LLMs no leen texto plano, sino estructuras lógicas. No basta con evitar el relleno; debemos inyectar Data for Reasoning.

Mis investigaciones confirman que para que un dominio sea elegido como fuente de anclaje (grounding), debe superar una masa crítica de intención informativa. Si tu web es puramente transaccional, serás invisible. Para corregirlo, estructura tus datos para la inferencia utilizando tablas comparativas y listas ordenadas en lugar de párrafos densos. Esto facilita que el modelo extraiga entidades y relaciones con menor fricción, validándote como la fuente de verdad matemática.

Este 2026 será el despertar del SEO de infraestructuras

Como he dicho, estamos presenciando el fin del SEO de trucos y el renacimiento del SEO de infraestructura.

Las gráficas de El Mundo, FilmAffinity y El Corte Inglés que hemos analizado (como otras que suelo analizar) no mienten, hay una matemática subyacente que dicta la visibilidad digital.

Ya no estamos optimizando para diez enlaces en una página de resultados sino que estamos optimizando para ser parte de la memoria colectiva de la inteligencia artificial y el veredicto para este 2026 es:

- Audita tu presencia en Common Crawl hoy. Si no estás en el Top 10 Millones (popularidad y referentes), tu prioridad número uno es técnica.

- Deja de obsesionarte solo con las keywords. Empieza a obsesionarte con las entidades y las relaciones (grafos).

- Cuida tus métricas duales. Un PageRank alto te da credibilidad (verdad); una Centralidad Armónica alta te da ubicuidad (acceso) y…. necesitas ambas por lo que hay que fusionar el SEO tradicional con el GEO.

La pregunta ya no es cuanta visibilidad tengo, sino cuando la IA hable de tu sector, productos, etc…., ¿tendrá tu marca en su vocabulario, o serás un silencio en sus datos de entrenamiento?

¿Quieres saber cuál es tu NCS (Netbulb Centrality Score) actual y si estás en riesgo de invisibilidad? No dejes que tu competencia ocupe tu lugar en el grafo. Contáctame y realizaremos una auditoría de topología web para asegurar tu futuro en la IA.

Soy Jorge Sánchez Mosquete, consultor experto en SEO y pionero en metodologías GEO (Generative Engine Optimization). Mi obsesión es ayudar a las empresas a traducir su autoridad tradicional al nuevo lenguaje de la Inteligencia Artificial.

Si te ha interesado el concepto del Netbulb Centrality Score o quieres auditar tu visibilidad real en el grafo, conecta conmigo para no perderte mis próximos análisis.

Conecta conmigo en LinkedIn:

Deja un comentario