Durante la última década, la industria del posicionamiento web se ha regido por la convicción de que la calidad del contenido actúa como el activo estratégico principal. Esta escuela de pensamiento establecía que la profundidad y la utilidad del texto eran garantes suficientes del rendimiento orgánico, una correlación que se mantenía estable bajo el paradigma clásico de la recuperación de información.

Sin embargo, hacia 2026, la consolidación de la búsqueda generativa a través de sistemas como SGE, AI Overviews o SearchGPT ha modificado sustancialmente las variables de éxito. Hemos transicionado de un modelo de competencia por palabras clave a uno basado en la autoridad sobre nodos de conocimiento.

En este nuevo contexto operativo, la calidad semántica del contenido pierde relevancia si la topología del sitio web es deficiente. Nos adentramos en una etapa donde la arquitectura de la información y la eficiencia del grafo superan en importancia a la redacción tradicional.

El procesamiento de información en modelos de lenguaje

Para comprender la pérdida de tracción de las estrategias de contenido convencionales, es necesario analizar cómo operan los modelos de lenguaje grandes (LLMs) y los sistemas RAG.

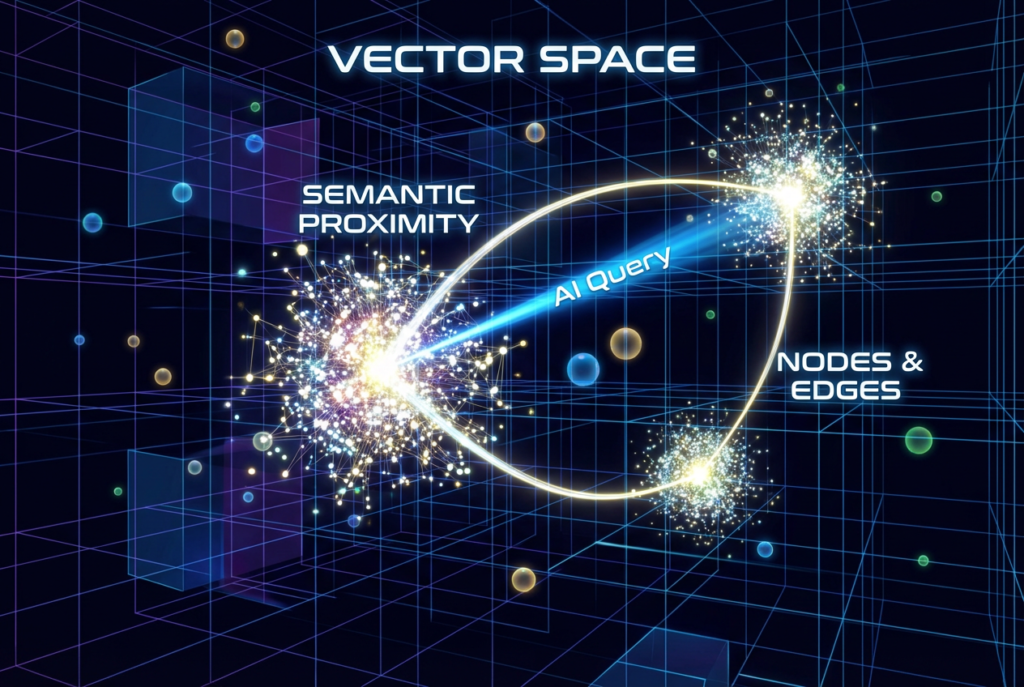

A diferencia de los rastreadores clásicos que indexan documentos basándose en la frecuencia de términos y la autoridad externa, un LLM opera mediante la vectorización de significados.

El espacio vectorial y la proximidad matemática

Un sitio web debe visualizarse no como una jerarquía de carpetas, sino como una red de nodos en un espacio tridimensional donde cada nodo representa un concepto o entidad, y cada arista simboliza la relación semántica que los une.

Cuando un usuario realiza una consulta compleja a un sistema como Gemini o ChatGPT, el modelo no busca coincidencias exactas de texto, sino que recorre su grafo de conocimiento para identificar conceptos que mantengan una proximidad matemática dentro de su espacio vectorial.

La problemática radica en la desconexión estructural, ya que si un sitio dispone de contenido excelente pero este se encuentra aislado topológicamente, el modelo no puede trazar la ruta de inferencia necesaria.

Aunque existan artículos técnicos de alta calidad y fichas de producto detalladas, si la distancia de clics entre ellos es excesiva y carecen de un enlazado semántico explícito, el sistema RAG interpretará estos nodos como islas desconectadas. Para reducir el coste computacional y evitar alucinaciones, el modelo priorizará aquellas fuentes que presenten una estructura de hub interconectado, aunque su contenido individual sea menos extenso.

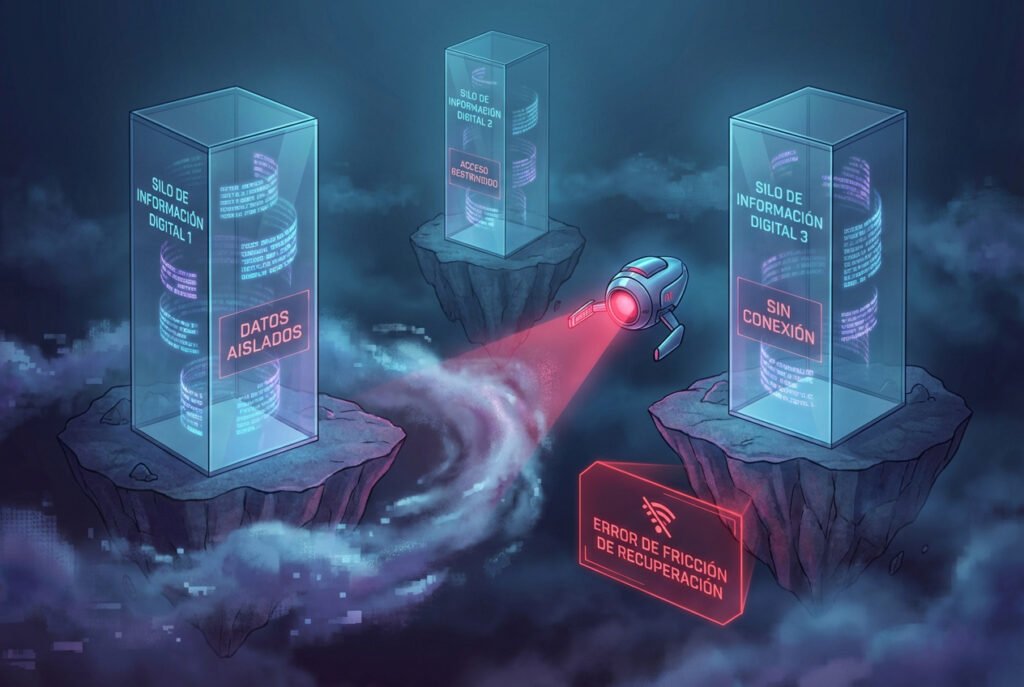

La ineficiencia de los silos de conocimiento

Uno de los errores arquitectónicos más frecuentes que detectamos en las auditorías actuales es la presencia de estructuras de silos verticales.

Los gestores de contenido tradicionales tienden a generar jerarquías lineales que descienden desde la página de inicio hasta el artículo final. Esta estructura, aunque válida para la navegación humana y el rastreo clásico, genera una alta fricción para los procesos de inferencia de la IA.

El caso del aislamiento estructural

En consultoría es común observar grandes corporaciones con blogs de alta calidad técnica que residen en subcarpetas aisladas, vinculados únicamente por una paginación cronológica.

A efectos de un motor generativo, este conocimiento se encuentra atrapado en un silo. Si no existe una malla interna que conecte transversalmente los conceptos informativos con las soluciones transaccionales, la IA no realizará esa asociación por sí misma ni inferirá relaciones que no estén explícitamente dibujadas en el grafo del sitio.

Esto deriva en la paradoja de encontrar dominios con alta autoridad temática que resultan invisibles en la respuesta generada por carecer de mapas de conexión claros.

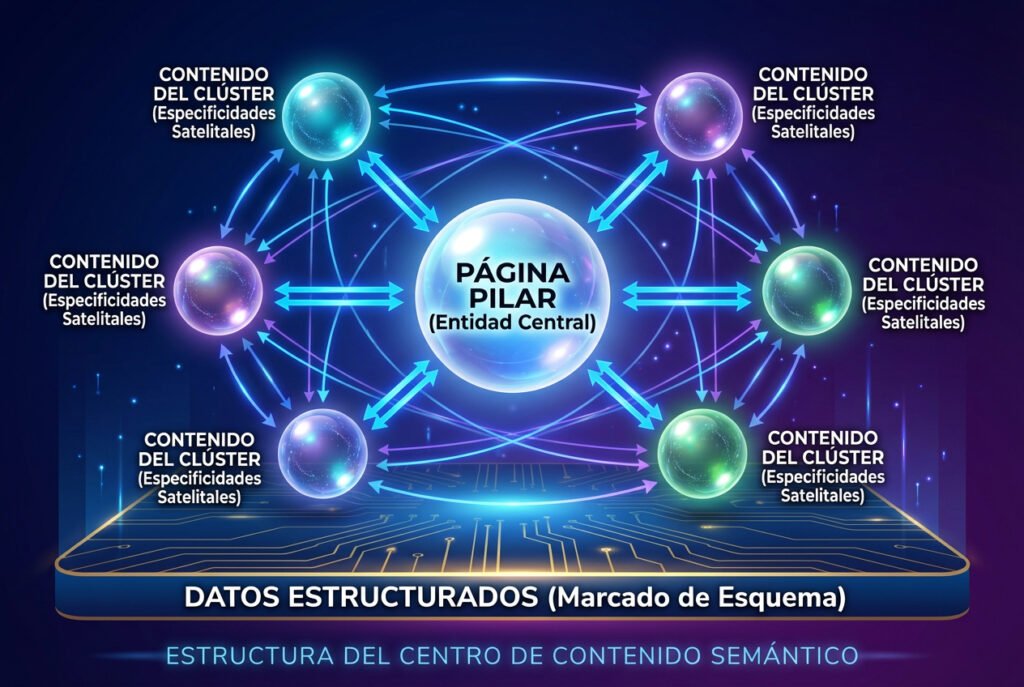

Del link building al hub building y la densidad interna

Históricamente, la inversión SEO se ha centrado en la adquisición de autoridad externa o link building. En la era GEO, la prioridad se desplaza hacia el hub building, entendido como la construcción de densidad interna.

Un hub semántico es una estructura diseñada para reducir la fricción de recuperación de la IA, la cual se compone de tres elementos técnicos fundamentales.

En primer lugar se encuentra la página pilar, que actúa como centro gravitacional del grafo y cuya optimización se basa en la definición de una entidad para desambiguar el concepto y distribuir la autoridad temática.

A su alrededor orbitan los clústeres de soporte, un conjunto de contenidos satélite que abordan especificidades y que se caracterizan por enlazar al pilar y entrelazarse entre sí mediante textos de anclaje semánticos. Esto indica al modelo que el concepto secundario es una propiedad o subconjunto del principal.

Finalmente, la estrategia se cierra con la inyección de datos estructurados, utilizando marcado Schema para definir no solo objetos, sino las relaciones entre ellos, transformando así una web de texto ambiguo en una base de datos legible por máquina.

La fricción de recuperación y el coste computacional

La insistencia en la estructura responde a criterios de eficiencia económica. Mis investigaciones recientes evidencian que los procesos de inferencia son extremadamente sensibles al coste de recuperación.

Cuando un modelo procesa una consulta en tiempo real, dispone de recursos limitados para entender la intención, recuperar fragmentos de información y sintetizar una respuesta. Si un sitio web presenta una alta fricción de recuperación, suele ser descartado por economía computacional.

Existen diversos factores que aumentan esta fricción topológica, tales como una profundidad de navegación excesiva donde el contenido se sitúa a más de cuatro niveles del nodo principal, o la dilución semántica provocada por enlaces internos con textos genéricos que no transmiten peso vectorial. Del mismo modo, la presencia de páginas huérfanas o el ruido estructural que dificulta la extracción del texto principal penalizan el rendimiento.

Existe una correlación directa donde una mayor profundidad y menor interconexión resultan en una menor probabilidad de citación en respuestas generadas, independientemente de la autoridad del dominio.

Matriz de transformación de SEO a GEO

La transición hacia el nuevo entorno digital exige replantear los conceptos clave de la estrategia.

Mientras que en el enfoque tradicional la unidad mínima era la URL, en el modelo GEO trabajamos con fragmentos de información o chunks, lo que nos obliga a estructurar el contenido en bloques lógicos independientes. Del mismo modo, el objetivo deja de ser el posicionamiento por palabras clave para centrarse en la conquista de entidades y conceptos, utilizando el marcado Schema para desambiguar.

La estructura también evoluciona desde una jerarquía de árbol hacia una topología de red, donde la implementación del enlazado transversal entre silos se vuelve crítica. Finalmente, la autoridad ya no se mide exclusivamente por los enlaces externos, sino por la densidad de información interna, priorizando la creación de hubs temáticos sobre la compra de enlaces.

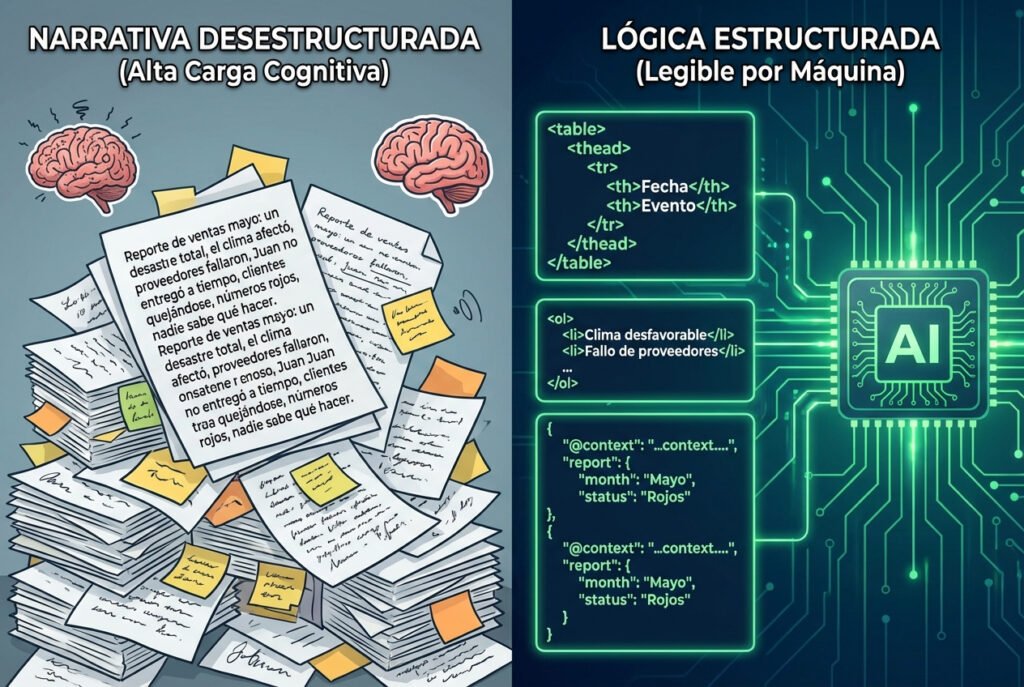

Inyección de lógica como nuevo estándar técnico

El SEO técnico ha evolucionado desde la optimización del rendimiento web hacia la inyección de estructura lógica, cuyo objetivo es facilitar la legibilidad para la máquina.

Los modelos buscan patrones de datos estructurados para reducir su carga cognitiva. Por ello, el uso de tablas HTML en comparativas permite la extracción directa de datos, mientras que las listas ordenadas facilitan la comprensión secuencial de procesos. De igual forma, las estructuras de pregunta-respuesta con encabezados directos mejoran significativamente la recuperación de definiciones.

Al presentar la información formateada lógicamente, validamos el dato ante la IA y aumentamos la probabilidad de ser la fuente elegida frente a competidores con estructuras narrativas densas y no procesadas.

Conclusión sobre la arquitectura de la información

El sector se encuentra en un punto de inflexión donde las tácticas basadas en volumen de publicación y autoridad bruta pierden eficacia frente a estrategias de precisión estructural.

La IA eleva el estándar técnico y filtra aquellos activos digitales que no presentan una organización lógica. Para mantener la competitividad en 2026, es imperativo dejar de concebir el sitio web como un repositorio lineal de noticias y gestionarlo como una biblioteca organizada.

Si se construye un grafo sólido y denso, la visibilidad deja de depender de las actualizaciones del algoritmo para basarse en la utilidad estructural. El sitio se convierte así en una fuente de verdad estructurada, el activo más demandado por los sistemas inteligentes.

En el próximo análisis abordaremos la métrica de la autoridad y evaluaremos matemáticamente la rentabilidad real de la adquisición de enlaces en este nuevo ecosistema.

Extra: Conceptos clave

Como hemos visto, la terminología del sector está evolucionando rápidamente. Para ayudarte a aterrizar estos conceptos abstractos en acciones tangibles, he sintetizado los cuatro pilares de esta transición en la siguiente matriz. Úsala como tu «piedra Rosetta» para traducir tus conocimientos actuales de SEO al nuevo lenguaje de los Motores Generativos:

| Concepto | Definición en contexto GEO | Acción recomendada |

| Topología Web | La estructura matemática de cómo se conectan las páginas (nodos) en un sitio web. | Auditar la profundidad de click y la densidad de enlaces internos. |

| Silos de Conocimiento | Contenido de alta calidad que está aislado estructuralmente y es invisible para RAG. | Implementar estrategias de Cross-Linking entre Blog y Producto. |

| Fricción de Recuperación | La dificultad computacional que tiene una IA para extraer un dato de tu web. | Usar tablas, listas y datos estructurados (JSON-LD) para reducirla. |

| Hub Building | La estrategia de crear clústeres de contenido densamente interconectados. | Crear páginas pilar y conectar todo el contenido satélite hacia ellas. |

Jorge Sánchez Mosquete

CEO de Netbulb y consultor especializado en GEO (Generative Engine Optimization) como SEO para las IAs.

Deja un comentario